Trebalo je ranije da otvorim ovaj thread, al eo ga sad, uz hype-a oko Deepseeka.

ChatGPT, Perplexity, Coopilot i ostali toolovi su pokrenuti na tudjem serveru, ako koristite neki od tih toolva imajte na umu da time pomazete proprietary software-u i pritom ugrozavate svoju privatnost, moguce je da se loguje i svaki vas prompt, tako da pazite i sta pisete. Poslednji put kad sam pogledao za registraciju na ChatGPT-u je potrebno ostaviti broj telefona.

Alternativa je da se lokalno pokrene LLM, pa bih probao jednostavno da objasnim kako poceti i koje su opcije.

- Ollama - meta-in open source program koji pokrece LLM-ove (github) , jednostavno za instalaciju

- Llama.cpp - malo kompikovanije, za mnoge OS je potrebno buildati ga llm gen guide

- PocketPal - za mobilni, iz nekog razloga nije na F-Droidu, voditi racuna da ne sprzite fon, moj se pregreva

Clients

- Spisak UI klienata

- Open web ui - msm da ima najvise feature-a

- Oatmeal - terminal user interface (TUI)

Instalacija

- ollama download ili install preko skripte, neki package manageri na linuxu ga vec imaju (znm za pacman)

- llama.cpp build guide, pre-built install

Sigurnija opcija je pokrenuti ih unutar virtualne masine ili containera (lxc, docker,…).

Modeli

- Ollama modeli se instaliraju preko komande koja se moze naci kod njih na sajtu, odabere se velicina modela i copy paste u terminal

- Llama.cpp je malo kompilovaniji, potrebno je skinuti model i onda ga gadjati komandom readme iz repoa

Na pitanje kako odabrati model, nisam siguran sta pravi odgovor, zavisi od jacine masine na kome se pokrece, kolko sam skapirao, radi valjda na 2 nacina,

- obradu vrsi CPU (procesor), a model se smesta u RAM (memoriju)

- obradu vrsi GPU (graficka karta), a model se smesta u VRAM (memoriju) od GPU

Nzm da li se memorije kombinuju i nisam siguran sta se desava ako model zauzima vise nego model, ali u tom slicaju modeli odgovraju drasticno sporije. Vodeci se ovime, jasno je da modeli mogu da se pokrenu na vecini masina, pogledati da li je vas GPU podrzan, instalirati nesto dodatno za podrsku ako treba, ako ne onda na CPU.

Dobra stvar je spremiti jedan na laptopu i imati “search engine”, za slucajeve ako se nadjete negde bez internet konekcije.

Preporuku za modele, birati tako da zauzima manje memorije nego sto masina ima slobodnog rama/vrama, da bi islo brzo, ako vam to nije bitno, nego preciznost odgovora, onda neki veliki i cekanje.

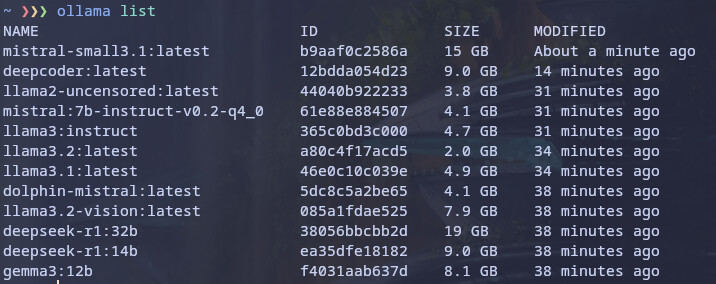

Modeli koje sam pokretao i valjaju (ovo se menja drasticno, posto izlaze novi non stop)

General (chat modeli)

- Deepseek 14b (9GB) i 32b (20GB)

- Mistral

- Mistral-small - 24b (14GB)

- Dolphin Mistral - 7b (4.1GB)

- Llama3.1 - 7b (4.9GB)

- LLama3.2 - 3b (2GB)

Instruct modeli

Ovi modeli su vise direktni sa odgovorima, “rade po instrukciji”

Code modeli

- probao sam par code modela, ali nisam nasao neki koristan, za python ih ima najvise tu se vrv moze naci neki koji je bolji od ovih generalnih

- codellama

- deepseekcoder

IDE assistenti (kao coopilot)

- Continue - VSCodium client

- ollama.nvim - NeoVim plugin

- oatmeal.nvim - NeoVim chat bot

Image reasoning modeli

- Llama 3.2 vision - prihvata sliku u promptu, moze procitati tekst sa slike OCR, meni je radilo kad prompt glasi “Can you do OCR on this image”

Disclaimer:

- Modeli cesto haluciniraju, izmisle odgovor, dosta informacija moze biti netacno itd

- Modeli odgovaraju u zavisnosti od podataka na kojima su trenirani. Obratite paznju kad je model izasao. Proveru mozete odraditi sa nekim desavanjem u svetu, tipa pitati ko je trenutni predsednik odredjene drzave, koja je poslednja verzija nekog software-a, itd.

- Neki modeli razumeju i odgovaraju i na srpskom

Subreddit r/LocalLLaMA

Ispravite me ako negde gresim, dopunite… pa bi mozda mogli ovo da pretvorimo u wiki stranu. GL&HF